Sitemap.xml — простой файл, в котором указывается информация про все страницы ресурса с метаданными о каждой. Файл помогает ресурсу ранжироваться в поисковой системе. Поисковый робот ориентируется на сайтмап и на его основе определяет количество URL-адресов, их обновления и частоту изменения. Составление sitemap — обязательное условие для поискового продвижения. Чтобы сайтмап работал на вас, его необходимо заказывать у опытных специалистов.

Какие есть требования к составлению sitemap

Существует несколько разновидностей карт сайта, но вне зависимости от того, какую будете создавать, ряд требований к файлу будет одинаковый. Рассмотрим основные требования к составлению сайтмап:

- файл должен содержать не больше 50000 адресов (исключение News Sitemap);

- Google требует фиксированный размер файла — не больше 50 Мб, но сайтмапы можно уменьшать через архивирование документов;

- у всех страниц должна быть общая форма записи;

- каждая ссылка должна быть абсолютной, то есть содержать домен;

- в адресе не может быть идентификатора сессии;

- сервер должен отдавать код “200 ОК”;

- поисковый бот индексирует только URL на 2048 символов;

- нужно использовать только стандарт кодирования UTF-8;

- в адресе должны быть только латиница и цифры;

- обязательно занести в robots.txt ссылку на сайтмап и файл индекса.

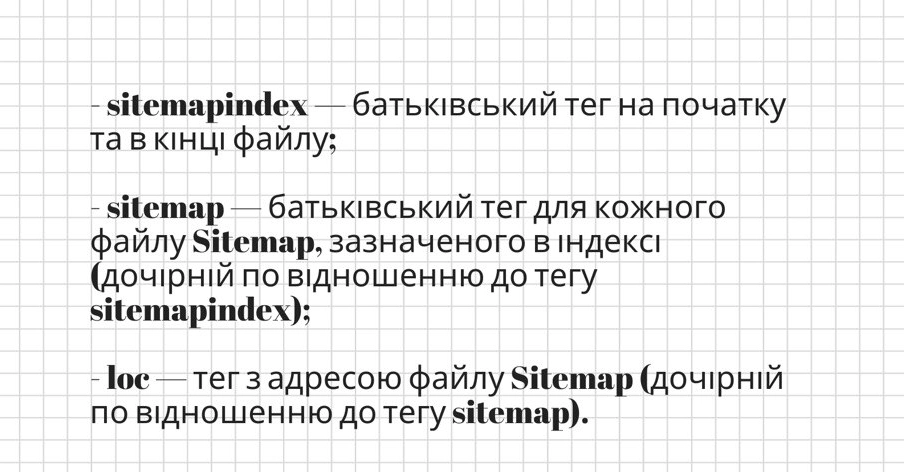

Если файл получился слишком большим, его можно разбить на несколько, но вместо отдельных сайтмап, в Гугл нужно отправить их индекс. Уделяйте особое внимание разным версиям ресурса. Если есть мобильная версия сайта, то ее страницы нужно указывать с аннотацией. Также внимательно работайте с версиями сайта на других языках. Для них поисковая система предлагает указывать через теги или атрибуты.

Возможные ошибки при составлении sitemap

Опытные сео-специалисты из Brander точно знают, как сделать сайтмап грамотно, но новички нередко допускают одни и те же ошибки. Самое главное заблуждение, что если страницы добавлены в сайтмап, то поисковая система их точно проиндексирует. Нужно понимать, что карта сайта выступает рекомендацией, подсказкой для робота, но это не дает гарантию автоматической индексации.

Не забывайте про общее качество ресурса. Гугл оценивает не только конкретные адреса, но и общее впечатление про сайт. На практике это может быть так: у нас есть 100 страниц, 10 из них входят в топ выдаче, а 90 остальных воспринимаются роботом как малоинформативный или не полезный контент. Если учитывать параметр общего качества, то разумным будет отключить индексацию 90 страниц с плохим показателем. Не забудьте после редакцию обновить файл sitemap.

Если у вас большой сайт и вы боитесь, что сайтмап придется настраивать вручную, не переживайте, вас дезинформировали. Есть динамические sitemap, которые автоматически и самостоятельно настраиваются под роботов. Вам даже не потребуется отправлять файл индекса в веб-сервис системы. Этот метод будет также полезен, если на сайте представлены разные виды контента.